모바일·가전은 물론 서버까지… 최소한 HBM2 4배 필요

삼성전자와 SK하이닉스가 3분기 사상 최대의 영업이익을 냈지만 이를 ‘고점’이라고 보는 시각이 팽배하다. 두 회사가 메모리 시장이 여전히 견고하며, 앞으로도 수요는 꾸준할 것이라고 설명하는데도 이같은 논란은 계속되고 있다.

메모리 시장 전망이 엇갈리는 이유는 무엇일까. 현장 취재로 각 주장의 근거를 분석하고 내년 메모리 시장을 예측해본다.

[네버 엔딩 메모리]② 수요는 늘어날 수밖에 없다 - AI

지난해부터 올해까지 이어진 서버 업계의 투자는 사실상 맛보기다. 인공지능(AI), 5세대(5G) 이동통신, 자율주행, 산업용 사물인터넷(IIoT) 등에 대한 투자는 이제 첫 발을 뗐다.

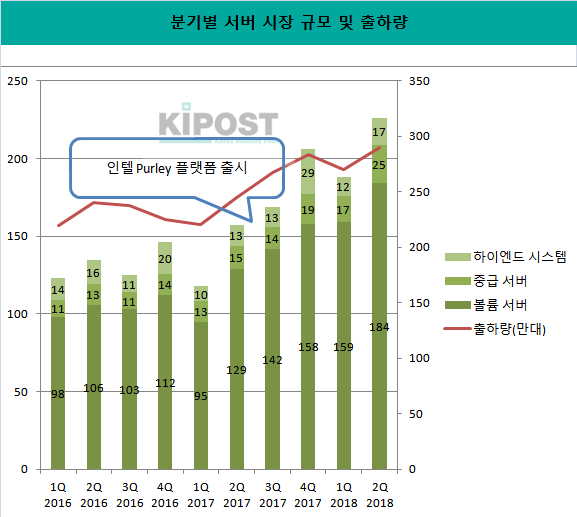

IDC에 따르면 지난해부터 올해 2분기까지 서버 업계의 투자는 대당 2만5000달러(약 2800만원) 이하의 저가 서버에 집중됐다. 미래 기술을 현실화하기 위해선 고성능컴퓨팅(HPC)을 구동할 수 있는 하이퍼스케일 데이터센터가 필요하다.

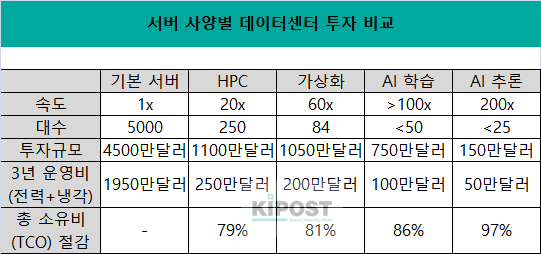

하이퍼스케일 데이터센터는 대당 25만달러(약 2억8000만원) 이상의 서버 최소 5000대로 구성된다. 지난해 말 세계 하이퍼스케일 데이터센터는 총 390여곳으로, 내년 말이면 500여곳으로 늘어날 전망이다.

메모리 수요 자극하는 AI

당장 내년 메모리 수요를 자극하는 건 AI다. 모바일 기기는 물론 가전 등 엣지(Edge) 기기에도 AI 기능이 확대 적용되고 있다. AI 기능이 추가되면 기본적으로 이를 저장, 구현할 수 있는 메모리가 필요하다. 일반적으로는 새로운 유형의 데이터의 수집을 대비해 각 연산자별로 D램을 탑재, 처리 속도를 높인다.

전력 소모량이 적어야한다는 점을 감안하면 D램으로는 LPDDR이 적합하다. 실제 아마존의 AI 스피커 ‘2세대 에코’ 1대에는 512MB LPDDR3와 4GB MLC 낸드가 내장돼있다.

모바일, 가전은 빙산의 일각이다. AI 투자의 핵심은 서버다. 글로벌 IDC 업계는 물론 삼성리서치, 현대모비스, 네이버랩스 등 국내 업체들도 내년 AI용 서버 구축에 최소 수십억원을 투자할 계획이다.

업계 관계자는 “북미에서만 150여개의 업체가 AI 서버를 구축할 계획이고, 중국 등 아시아 지역에서도 AI 기술 개발에 한창”이라며 “AI 시장은 올해 몇 개의 선도업체를 중심으로 시작됐고 내년부터 투자가 본격화될 것”이라고 말했다.

AI 알고리즘은 학습 데이터가 많을수록 알고리즘이 정교해진다. 때문에 얼마만큼의 성능을 가진 서버가 필요한지 가늠하기 어렵다.

때문에 업계는 지금까지 기존 CPU 기반 서버에 그래픽처리장치(GPU)나 프로그래머블반도체(FPGA) 기반 가속기를 꽂아 고성능컴퓨팅(HPC) 서버를 구성해 AI 알고리즘을 개발, 적용해왔다.

알고리즘을 만들 때는 GPU를, 이를 적용(Inference)할 때는 FPGA를 쓰는 식이다.

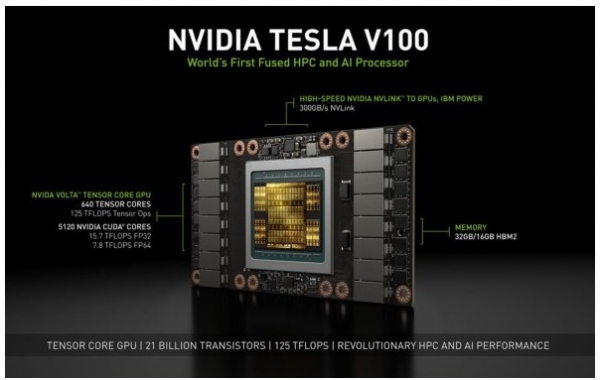

이때 GPU나 FPGA에는 그래픽D램보다 초당 데이터 처리량이 많은 고대역폭메모리(HBM)가 기본적으로 내장돼있다. (2018년 7월 23일 KIPOST <네이버, 서버용 AI 칩 만든다… 이르면 연내 출시>)

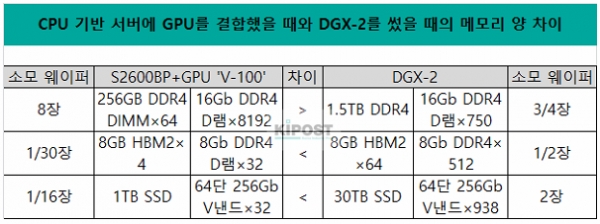

엔비디아의 서버용 GPU ‘파스칼 볼타(V)-100’를 기준으로 보자. ‘파스칼 V-100’에는 8GB HBM2 4개가 내장돼있다. 삼성전자의 제품이라고 가정하면 내부에 20나노 8Gb D램이 각 8개, 총 32개 들어간다.

삼성의 20나노 8Gb D램의 다이(Die) 크기는 62.99㎟ 정도로, 300㎜ 웨이퍼 한 장에 최대 1120여개를 만들 수 있다. 즉 ‘파스칼 V-100’ 하나가 팔릴 때마다 300㎜ 웨이퍼 4분의1 정도가 쓰인다.

서버 1대에는 최대 8개의 GPU와 20개의 CPU를 넣을 수 있다. 인텔의 ‘펄리 플랫폼’ 20개과 엔비디아 ‘파스칼 V-100’ 8개로 서버를 구성하면 300㎜ 웨이퍼 165장 분량의 D램이 필요하다.

SSD는 수십 TB가 적용된다. 삼성전자의 64단 256Gb 3bit V낸드를 기준으로 1TB 모듈을 구성하려면 V낸드 32개가 필요하다. 64단 낸드의 다이(die) 사이즈는 130㎟. 300㎜ 웨이퍼 한 장당 최대 543개가 들어갈 수 있으니 20TB만 넣는다 해도 웨이퍼 1장 이상 분량이다.

하지만 이 방식으로는 효율성이 떨어진다. 기존 CPU 기반 서버에 넣으면 발열과 전력소모량이 커져 어차피 서버가 들어갈 공간을 개조해야하는데다, 운영비도 커지기 때문이다. 값비싼 CPU도, 공간만 차지하는 랙도 AI에는 필요 없다.

내년부터는 GPU 기반 AI 전용 서버가 본격 판매된다. 국내에서도 삼성리서치와 네이버랩스, 현대모비스가 내년 GPU 기반 AI 서버를 구축할 계획이다.

엔비디아 관계자는 “데이터센터 신설 및 운영 비용이 부담스러워진 IT 업계가 GPU 기반 AI 전용 서버를 구축하기 시작했다”며 “현재 CPU 기반 AI 서버가 세계 서버 시장의 5% 미만에 불과한 만큼 빠르게 시장을 늘릴 수 있을 것”이라고 말했다.

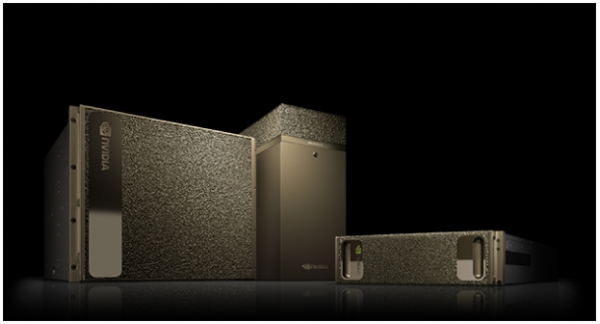

GPU 기반 AI 전용 서버는 엔비디아가 유일하게 공급한다. ‘DGX-1’과 ‘DGX-2’로, 각각 2억원, 5억원이다. ‘DGX-2’ 1대는 CPU 300개가 들어있는 랙 15개를 대체할 수 있다.

‘DGX-2’에는 ‘테슬라 V-100’ GPU 16개에 각 8GB HBM2 4개씩, 총 64개의 HBM2 모듈과 시스템 내 1.5TB 용량의 DDR4 D램, 30TB 혹은 60TB의 NVMe SSD가 탑재된다.

즉 ‘DGX-2’ 1대에는 20나노 8Gb D램 512개, 시스템 내 16Gb DDR4 D램 750개, 30TB SSD에는 64단 256Gb V낸드 938개가 들어간다.

‘DGX-2’에 들어가는 메모리의 총량은 CPU 1개가 탑재된 서버에 GPU 1개를 결합했을 때보다 적다. 하지만 GDDR5보다 단가가 3배 높은 HBM이 16배나 많이 들어가고 비교적 최신 공정이 활용되는 시스템용 메모리는 1편에서 지적했듯 AI 기능이 들어가지 않는 일반 서버, PC 등에서도 수요가 높다.

현재 HBM2를 양산할 수 있는 곳은 삼성전자와 SK하이닉스 뿐이다.

시장조사기관 리서치앤마켓에 따르면 올해 HBM 시장은 총 9억2270만달러(약 1조496억원)로 추산된다. HBM2 하나를 170달러(약 20만원)로 가정하면 연간 54만8000여개가 출하되는 셈이다.

전체 서버 시장에서 AI 서버는 5% 미만을 차지하고 있다. 엔비디아는 AI의 영향으로 고성능컴퓨팅(HPC)과 AI 학습 및 추론 데이터센터의 총 유효시장(TAM)이 오는 2020년 총 300억 달러(약 56조5300억원) 규모로 성장할 것이라고 봤다.

지난해 기준 전체 서버 시장 650억달러(약 73조5280억원) 중 5%(32억5000만달러)가 AI 서버라고 가정해도 연평균성장률은 110%에 달한다.

이대로 내년 AI 서버 시장의 규모를 추산하면 143억달러(16조1819억원)로, ‘DGX-2’로만 AI 서버를 구성한대도 3만2000여대. HBM2으로는 204만8000여개 물량이다. 즉, 내년에는 올해보다 4배 많은 HBM2를 내놔야한다.

CPU 기반 서버에 GPU나 FPGA를 결합한다면 HBM의 수요는 줄어들지만, 최신 공정 DDR4 기반 DIMM의 수요가 그만큼 늘어난다. 엔비디아 ‘DGX-2’만큼의 성능을 내려면 CPU 300개가 있는 서버 15랙을 구축해야한다. 어떤 구성으로 구축하든, 메모리의 수요 증가는 반드시 따라온다.