마이크론, 25%에서 30%로 감산폭 확대

AI용 GPU 호황은 HBM 수요만 창출

SK하이닉스가 8~9월 메모리반도체 추가 감산에 들어간다. 최근 AI(인공지능) 서비스 확대에 힘입어 GPU(그래픽처리장치) 등 일부 시스템반도체 경기가 살아나고 있지만, 메모리반도체 전반으로 온기가 전해지지는 않고 있다.

앞서 업계 3위 미국 마이크론 역시 분기 실적발표를 통해 추가 감산을 발표한 바 있다.

SK하이닉스, 8~9월 5% 추가 감산

그동안 SK하이닉스의 메모리반도체 감산 규모는 웨이퍼 투입량 기준 20% 정도인 것으로 추산됐다. SK하이닉스의 웨이퍼 투입량 최대치는 D램 월 40만장, 낸드플래시는 월 20만장 정도다. 20% 감산이라는 의미는 ‘웨이퍼 인(Wafer In)’ 규모를 48만장 안팎까지 줄였다는 뜻이다.

SK하이닉스는 최근 소재⋅부품 업체들에게 오는 8~9월 발주량을 이전 대비 5% 정도 더 줄였다. 감산폭으로 보면 예년보다 25% 감소시킨 것으로, 웨이퍼 투입량으로는 45만장 이하로 떨어질 것으로 보인다.

한 반도체 소재업계 전문가는 “SK하이닉스가 8~9월 입고될 소재 발주량을 5% 정도 더 줄였다”며 “D램 보다는 낸드플래시 분야 감산폭이 더 크다”고 말했다. 3개 회사가 시장의 90% 이상을 좌우하는 D램과 달리 낸드플래시는 대여섯개 업체가 난립했다. 업황 회복이 D램 대비 더욱 늦을 수 밖에 없다.

SK하이닉스가 8~9월 발주를 줄였다는 건 아무리 빨라도 연말까지 메모리 시황이 나아질 가능성은 없다는 의미다. 통상 웨이퍼가 장비로 투입된 뒤, 완제품으로 출고되는데까지는 3개월이 걸린다. 9월에 투입된 웨이퍼는 12월은 되어야 완제품으로 나온다. 만약 4분기쯤 메모리 시황이 나아질 것으로 봤다면 SK하이닉스는 8~9월 소재⋅부품 발주를 줄이지 않을 것이다.

앞서 마이크론 역시 추가 감산을 발표했다. 마이크론은 지난 28일 실적발표 후 열린 컨퍼런스콜을 통해 “최근 D램과 낸드플래시 웨이퍼 투입량을 (기존 25%에서) 30%까지 더 줄였다”고 밝혔다. 지난해 10월 메모리 빅3 업체 중 가장 먼저 감산에 돌입한 마이크론은 이 같은 감산 기조를 내년까지 이어갈 것이라고 설명했다.

업계 1위 삼성전자는 메모리 3사 중 가장 늦은 올해 초 감산에 들어갔는데, 아직 추가 감산과 관련한 정황은 없다.

GPU만 호황인 AI 반도체 사이클

메모리반도체 업계의 이 같은 추가 감산 움직임은 엔비디아를 필두로 한 ‘AI 반도체’ 호황 사이클과는 온도차가 크다. 최근 엔비디아는 A100⋅H100으로 대표되는 서버용 GPU 수요가 크게 늘면서 시가총액이 1조달러(약 1318조원)를 돌파하는 등 전성기를 구가하고 있다.

그러나 AI 반도체 호황 사이클은 메모리반도체 수요 중 서버, 그 중에서도 GPU 연산에 특화된 AI 서버 산업에 국한된다. 메모리 시황은 살아나지 않지만 A100⋅H100에 이어 붙이는 HBM(고대역폭메모리) 수요만 크게 늘고 있는 걸 봐도 알 수있다.

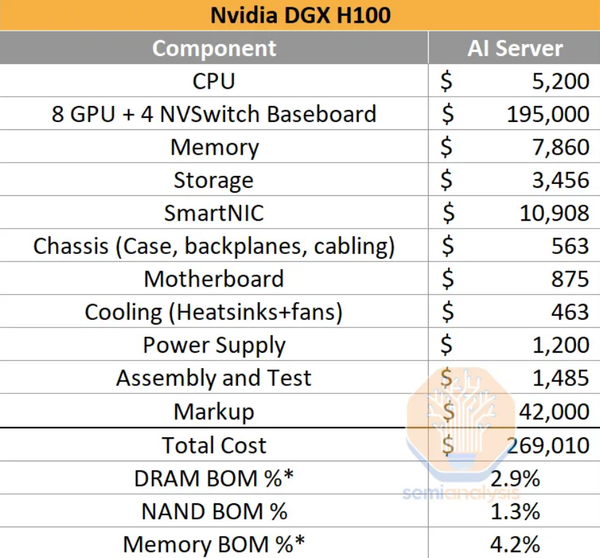

애초에 AI 서버 출하 증가로 인한 메모리 반도체 수요 창출 효과가 기대에 미치지 못한다는 분석도 있다. 시장조사업체 세미애널리시스에 따르면 인텔 사파이어래피즈가 적용된 일반 서버(1대당 1만474달러)에서 D램의 BOM(부품원가) 비중은 37.5%, 낸드플래시 비중은 14.7%에 달한다. 메모리 전체로는 서버 BOM의 52.5%를 차지하는 것이다.

그러나 엔비디아 H100이 적용된 AI 서버에서는 얘기가 달라진다. D램의 BOM 비중은 2.9%, 낸드는 1.3%에 불과하다. 메모리 전체로는 4.2% 정도다. 단가 비중으로만 보면 AI 서버에서 메모리가 볼 수혜는 제한적이라는 뜻이다.

물론 이 같은 계산은 AI 연산용 H100 8개 가격(19만5000달러)이 포함된데 따른 착시 효과를 무시할 수는 없다. 인텔 CPU가 탑재된 일반 서버 가격은 1대에 1만달러 남짓이지만, H100이 탑재된 AI 서버는 한 대에 27만달러다. AI 서버 전체 가격이 워낙 비싸다 보니 그 안에 들어가는 메모리 값이 낮아 보일 뿐이다. 그렇다 하더라도 GPU 시장 확대 비중과 함께 따려봤을 때, 메모리 수요가 늘어나는 효과가 제한적인 것은 사실이다.

딜런 파텔 세미애널리시스 연구원은 “AI 서버 원가 분석만 놓고 보면 메모리 반도체는 가장 큰 피해자(Loser)”라며 “GPU 시장이 확대되는 정도에 비해 메모리 시장 확대 효과는 미미하다”고 말했다.