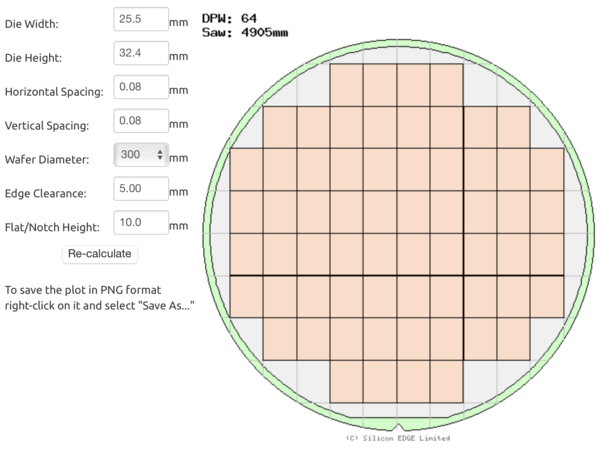

웨이퍼 한장에 64개 A100 생산 추정

AI 서버 출하, CoWoS 처리량에 달려

AI(인공지능) 서버 시장의 병목이 되고 있는 TSMC의 CoWoS(칩온웨이퍼온서브스트레이트) 공정 처리능력은 외부로 공표된 적은 없다. 현지 언론을 통해 300㎜ 웨이퍼 환산 월 8000~9000장 정도를 처리할 수 있다는 정도만 전해지고 있다.

KIPOST는 엔비디아의 대표적인 AI 서버용 GPU(그래픽처리장치) A100을 기준으로, 현재 TSMC의 CoWoS 처리량이 몇 대의 AI 서버에 대응하는지를 가늠해봤다.

300㎜ 웨이퍼에서 64개 A100 생산

최고 성능의 서버용 GPU인 A100은 다이 사이즈가 큰 ‘빅 칩’이다. 가로 25.5㎜, 세로 32.4㎜에 면적은 826㎜²에 이른다. 압도적 성능을 구현했다는 애플의 M2 면적이 141.7㎜²다. 컨슈머용 칩과 서버용 칩의 차이가 있기는 하지만, M2와 비교해 A100이 얼마나 큰지 알 수 있다.

A100처럼 큰 GPU를 300㎜ 웨이퍼 상에서 만들면 웨이퍼 1장당 64개를 취할 수 있다. 현재 알려진 것처럼 TSMC가 300㎜ 웨이퍼 환산, 월 최대 9000장의 CoWoS 처리량을 보유하고 있다면 월 57만6000개(9000장 X 64개)의 A100을 패키지 할 수 있다는 뜻이다. 연간으로 690만개 정도다.

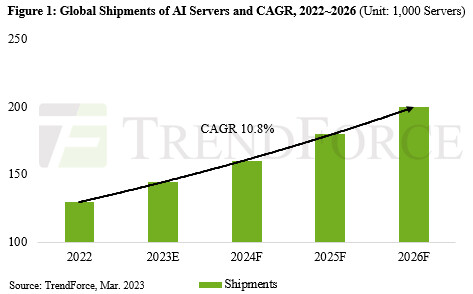

이 숫자를 AI 서버 시장과 대응시켜 봐야 한다. 엔비디아 A100은 1~8개의 GPU가 1대의 AI 서버를 구성한다. AI 서버 한 대에 평균 4개의 GPU가 탑재된다고 가정하면 690만개의 A100 패키지는 AI 서버 172만대분에 해당한다. GPU 탑재량을 늘려 AI 서버 한 대에 평균 6개 GPU가 탑재된다면, 출하 가능한 AI 서버의 수는 연간 115만대로 줄어든다.

시장조사업체 트렌드포스는 지난해 AI 서버 출하량을 130만대, 올해는 150만대 정도로 추정한다. 115만~172만대분 언저리인 TSMC의 CoWoS 처리능력과 AI 서버 출하량 전망치를 비교하면 왜 CoWoS가 AI 서버 출하의 병목이 되고 있는지 어렴풋이나마 알 수 있다.

한 반도체 산업 전문가는 “A100이 생산되는 TSMC의 N7(7나노) 공정 생산능력과 메모리 회사들의 HBM(고대역폭메모리) 생산능력에 비해 CoWoS 처리량이 턱없이 부족하다”고 말했다.

따라서 최근 AI 서버 수요가 크게 증가하고 있지만, TSMC의 CoWoS 처리능력이 단기에 늘지 않는다면 AI 서버 출하량 성장 역시 제한적일 수 밖에 없다. 앞서 지난 9일 TSMC는 첨단 패키지 생산공정을 위한 전용공장(주난 AP6)를 준공했다.

다만 이는 3개동으로 구성된 AP6의 1개동(AP6A) 외형이 갖춰졌다는 뜻으로 생산 장비는 순차적으로 입고되는 중이다. AP6 준공이 곧바로 CoWoS 생산능력 확대를 의미하지는 않는다. 오히려 TSMC는 OSAT(외주패키지⋅테스트) 업체인 미국 앰코테크놀로지, 대만 ASE로 하여금 CoWoS 처리능력 투자를 독려하고 있다.

본격적인 CoWoS 처리량 확대는 TSMC 인하우스 역량보다 OSAT 쪽에서 더 크게 일어날 수 있다는 뜻이다(KIPOST 2023년 6월 6일자 <AI 반도체, TSMC CoWoS 공정이 병목> 참조).