실리콘 및 소프트웨어 IP 전문기업 Ceva는 2일 자사의 Ceva-NeuPro(뉴프로), 에지 AI NPU 제품군을 확장한 Ceva-NeuPro-Nano(뉴프로-나노) NPU를 공개했다.

Ceva-NeuPro-Nano NPU는 고효율 및 독립형 NPU로 반도체 및 OEM 업체가 가전, 산업 및 범용 AIoT 제품에 사용되는 시스템온칩(SoC)에 초소형 머신러닝(TinyML) 모델을 통합하는 데 필요한 전력, 성능 및 비용 효율성을 제공한다.

TinyML은 저전력 디바이스에 머신러닝 모델을 실행해 AI 기능을 IoT에 적용하는 것을 의미한다. IoT 디바이스에서 효율적이고 전문화된 AI 솔루션에 대한 수요가 증가함에 따라 TinyML 시장은 급성장하고 있다. 시장조사업체 ABI 리서치는 2030년까지 TinyML 출하량의 40% 이상이 일반적인 마이크로 컨트롤러(MCU)가 아닌 TinyML에 특화된 전용 하드웨어로 구동될 것으로 전망한 바 있다.

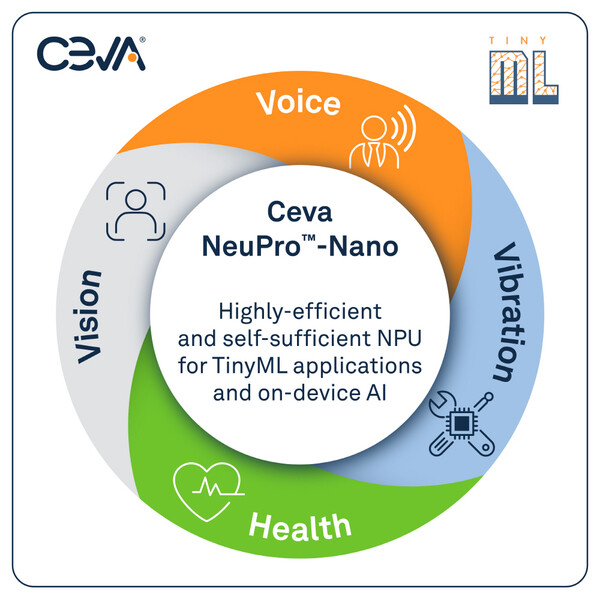

Ceva-NeuPro-Nano NPU는 TinyML의 특정 성능 문제를 해결해 음성, 비전, 예지 보전 및 헬스 센싱 등 가전 및 산업용 IoT 애플리케이션에서 AI를 광범위하게 사용하고, 경제적 및 실용적으로 활용할 수 있도록 돕는다.

새로운 Ceva-NeuPro-Nano 임베디드 AI NPU 아키텍처는 신경망(Neural Network), 특징 추출(Feature extraction), 제어 코드 및 DSP 코드를 효율적으로 실행할 수 있도록 프로그래밍이 가능하다. 또 네이티브 트랜스포머 계산, 희소성 가속 및 빠른 양자화 등 최신 머신러닝 데이터 형식 및 연산을 지원한다.

Ceva-NeuPro-Nano NPU는 최적화된 독립형 아키텍처를 통해 CPU 또는 DSP와 AI 가속기를 함께 사용하는 기존의 TinyML 워크로드 프로세서 솔루션과 비교해 더 작은 실리콘 풋프린트로 최적의 성능 및 뛰어난 전력 효율성을 제공한다. 이와 함께 Ceva-NetSqueeze AI 압축 기술을 통해 중간 압축 해제 단계 없이 압축된 모델 가중치를 직접 처리해 메모리 풋프린트를 최대 80%까지 줄일 수 있다.

Ceva-NeuPro-Nano NPU는 32개의 int8 MAC을 갖춘 Ceva-NPN32와 64개의 int8 MAC을 갖춘 Ceva-NPN64 총 두 가지 구성으로 제공되며, 두 구성 모두 압축된 모델 가중치를 직접 처리하기 위한 Ceva-NetSqueeze 기술이 적용됐다.

Ceva-NPN32는 음성, 오디오, 객체 탐지 및 이상 탐지(anomaly detection)를 위한 대부분의 TinyML 워크로드에 최적화됐다. Ceva-NPN64는 가중치 희소성(weight sparsity), 더 큰 메모리 대역폭 및 더 많은 MAC 사용과 4비트 가중치 지원을 통해 성능을 2배로 향상시키며 이를 통해 객체 분류, 얼굴 감지, 음성 인식 및 건강 모니터링 등 보다 복잡한 온디바이스 AI 사용 사례에 향상된 성능을 제공한다.

이 두 가지 NPU는 AI 소프트웨어 개발 키트(SDK) Ceva-NeuPro Studio와 함께 제공된다. Ceva-NeuPro Studio는 통합 AI 스택으로 전체 Ceva-NeuPro NPU 제품군에 걸쳐 공통 툴 세트를 제공하고, 마이크로컨트롤러용 텐서플로 라이트(TensorFlow Lite for Microcontrollers, TFLM)와 마이크로TVM(μTVM)과 같은 오픈 AI 프레임워크를 지원한다.