이미 2016년부터 AP에 NPU 내장

경량화된 LLM 정확도 높아지며 온디바이스AI 구현

근래 IT 업계 화두는 단연 ‘온디바이스AI’다. 대규모 클라우드 서버와의 통신을 통해 제공되던 AI(인공지능) 서비스를 스마트폰⋅노트북PC 등 엣지 자원으로만 구현하는 게 온디바이스AI다.

진정한 온디바이스AI 구현을 위해서는 기존 NPU(신경망처리장치) 수준을 뛰어 넘는 하드웨어 뿐만 아니라 적은 수의 파라미터(매개변수)로 구동되는 LLM(거대언어모델) 출현도 뒤따라야 한다.

스마트폰 내 NPU, 이미 AI 기능 구동

사실 모바일 기기에서 클라우드 지원 없이 단독 구현되는 AI 기능은 낯설지 않다. 이미 대부분의 플래그십 스마트폰의 AP(애플리케이션프로세서)에는 NPU가 내장돼 있다.

애플은 지난 2017년 공개한 ‘A11 바이오닉'부터 별도로 바이오닉이라는 별칭을 더했는데 이는 칩 내에 NPU가 내장돼 있다는 의미다. 퀄컴은 이보다 1년 앞서 2016년에 출시된 ‘스냅드래곤 820’에 처음 NPU를 내장했다. 아직 온디바이스AI라는 용어가 정착되지 않았을 뿐, 스마트폰 대부분이 AI 기능을 지원하고 있었던 셈이다.

다만 지난 7~8년간 온디바이스AI가 전면에 등장하지 않았던 건, AP에 내장된 NPU 성능이 ‘챗GPT’ 등 생성형 AI 서비스를 구동할 만큼 강력하지 못한 탓이다.

애플이 처음 내놓은 A11 바이오닉의 NPU 성능은 600GOPS(1초에 10억번 연산)에 불과했다. 최근 AI 업계에서 GOPS 단위는 쓰이지도 않는다. 애플이 지난해 출시한 ‘A17 프로’의 NPU 성능은 35TOPS(1초에 1조번 연산)에 달한다. 6년만에 NPU 성능이 60배 개선됐다. CPU 성능이 1년에 15% 안팎 앞으로 내딛는 것도 버거운 점을 감안하면, NPU의 속도 개선은 눈부셨다.

덕분에 스마트폰 내에서 카메라 포커스 조정 등 제한적 기능에만 사용되던 AI가 이제는 기능 전반에 활용할 준비가 됐다. 한 NPU 산업 전문가는 “사실 지난해까지 출시된 스마트폰들의 NPU는 제대로 활용되지 못하고 SoC(시스템온칩) 내 공간만 점유하는 측면이 없지 않았다”며 “온디바이스AI를 표방하는 스마트폰들은 NPU를 십분 활용할 수 있는 기능들을 포함해서 출시될 것”이라고 말했다.

“적은 파라미터로도 AI 구현” 경량화되는 LLM

다만 단순히 NPU 속도만 빨라진다면 온디바이스AI라 할 만큼 패러다임의 전환을 이루지는 못할 수도 있다. NPU 성능이 개선되는 트렌드 못지 않게 최근 경량화된 LLM의 정확도가 높아지고 있다는 점도 온디바이스AI 시대를 앞당기는 기폭제가 되고 있다.

그동안 AI 연구자들 사이에서는 파라미터 수를 늘릴수록 생성형 AI의 정확도가 높아진다는 게 정설이었다. 파라미터는 AI가 정보를 학습하고 기억하는 시냅스(신경연결) 역할을 한다. 빅테크의 AI 투자도 최대한 파라미터 규모를 키우고, 이를 소화할 수 있는 하드웨어 자원을 확보하는 데 초점이 맞춰졌다. AI 투자 붐과 함께 엔비디아의 고성능 GPU(그래픽처리장치) 수요가 촉발됐던 이유다.

그러나 클라우드에서 AI를 구현하는 것과 달리, 모바일 기기에서는 파라미터를 늘리고 하드웨어를 확장하는데 한계가 따른다. 프로세서와 메모리가 커질수록 개인이 소유하기에는 비용문제가 커지고, 무게도 무거워지기 때문이다.

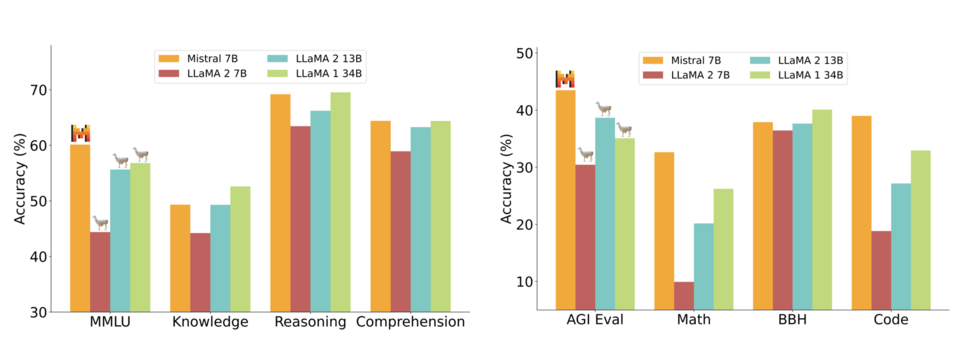

경량화된 LLM은 이러한 한계를 극복하기 위해 적은 수의 파라미터로도 정확도 높은 생성형 AI를 구현하는 게 목표다. 예컨대 프랑스 스타트업 미스트랄AI의 오픈 소스 모델 ‘미스트랄 7B’는 단 70억개의 파라미터만으로도 기존 생성형 AI에 버금가거나, 더 정확한 결과값을 출력한다. 생성형 AI의 표준으로 꼽히는 ‘GPT3’가 1750억개의 파라미터로 구성된다는 점을 감안하면 25분의 1 수준에 불과하다.

그동안 경량화 LLM의 선두주자는 메타(옛 페이스북)가 개발한 ‘라마(LLaMA)’였다. ‘라마2’는 파라미터 개수에 따라 7B(70억개), 13B(130억개), 34B(340억개)로 출시됐는데, 미스트랄 7B의 정확도는 34B와 비슷하거나 오히려 앞서는 것으로 측정된다.

특히 라마2 7B나 미스트랄 7B처럼 100억개 미만의 파라미터로 구동되는 LLM의 등장은 온디바이스AI 산업에는 함의가 크다. 최근 온디바이스AI 스마트폰을 표방하며 출시되는 제품들이 대부분 이정도 규격에 맞춰져 있기 때문이다.

지난해 10월 퀄컴이 출시한 ‘스냅드래곤8 젠3’는 100억개 수준의 파라미터를 보유한 생성형AI 모델을 지원한다. 스냅드래곤8 젠3는 이달 출시되는 삼성전자 ‘갤럭시S24’를 포함해 올해 안드로이드 진영 대부분의 플래그십 스마트폰에 탑재된다. 이를 감안하면 올해부터 출시되는 스마트폰은 대부분 라마2 7B나 미스트랄 7B 정도는 구동할 수 있는 하드웨어를 갖추고 나오는 것이다.

한 AI 산업 전문가는 “올해는 하드웨어 측면에서 NPU의 성능과 경량화된 LLM의 정확도가 교차하는 ‘골든 크로스'가 일어나는 해”라며 “기술적으로 온디바이스AI가 개화할 준비는 다 됐다”고 말했다.