엔비디아(www.nvidia.co.kr, CEO 젠슨 황)가 엔비디아 H100 텐서 코어 GPU(NVIDIA H100 Tensor Core GPU)가 본격 생산되고 있다고 21일 밝혔다. 아울러 글로벌 기술 파트너들은 10월에 획기적인 엔비디아 호퍼(NVIDIA Hopper™) 아키텍처를 기반으로 한 첫 번째 제품 및 서비스를 출시할 계획이다.

지난 4월 공개된 H100은 800억 개의 트랜지스터로 제작됐으며 다양한 기술 혁신이 적용됐다. 그중에는 강력한 새로운 트랜스포머 엔진(Transformer Engine)과 NV링크(NVLink®) 인터커넥트가 포함되어 있는데, 이를 통해 고급 추천 시스템과 대용량 언어 모델과 같은 최대 AI 모델을 가속화하고 대화형 AI와 약물 발견과 같은 분야의 혁신을 주도할 수 있다.

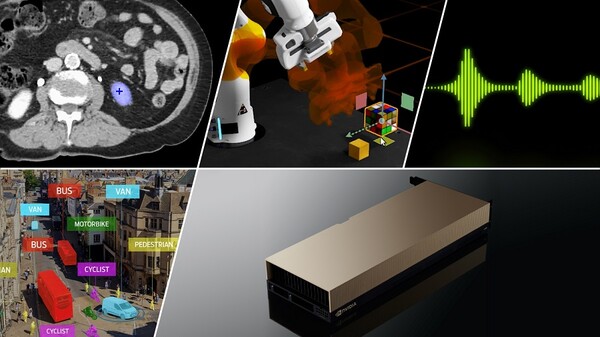

H100 GPU는 호퍼의 아키텍처와 트랜스포머 엔진 외에도 주요 혁신 기술을 탑재하고 있다. 엔비디아 엔터프라이즈(NVIDIA AI Enterprise) 소프트웨어 제품군에 대한 5년 사용권이 메인스트림 서버용 H100에 포함돼 있다. 이를 통해 AI 워크플로우의 개발과 배치를 최적화하고 사용기관이 AI 챗봇, 추천 엔진, 비전 AI 등을 구축하는 데 필요한 AI 프레임워크와 도구에 액세스할 수 있다.

H100을 통해 기업은 이전 세대보다 5배 적은 서버 노드를 사용하면서 3.5배 더 높은 에너지 효율성과 3배 더 낮은 총 소유 비용으로 동일한 AI 성능을 제공해 AI 배포 비용을 절감할 수 있다.

엔비디아는 신기술을 경험해보고자 하는 고객을 위해 현재 델 파워엣지(Dell PowerEdge) 서버의 H100을 엔비디아 런치패드(LaunchPad)에서 사용할 수 있다고 발표했다. 엔비디아 런치패드는 기업들이 최신 하드웨어와 엔비디아 AI 소프트웨어에 액세스할 수 있도록 지원한다.

또 8개의 H100 GPU를 포함하고 32페타플롭의 성능을 FP8 정밀도로 제공하는 엔비디아 DGX™ H100 시스템도 주문이 가능하다. 엔비디아 베이스 커맨드(Base Command™) 와 엔비디아 AI 엔터프라이즈 소프트웨어가 모든 DGX 시스템에 전원을 공급해 단일 노드에서 엔비디아 DGX 슈퍼POD(NVIDIA DGX SuperPOD™) 로 배포하여 대규모 언어 모델과 기타 대규모 워크로드의 고급 AI 개발을 지원한다.

세계 유수 컴퓨터 제조업체들의 H100 동력 시스템은 앞으로 몇 주 안에 출하될 것으로 예상되며, 연말까지 50개 이상의 서버 모델이 시장에 출시되고 2023년 상반기에는 수십 개가 더 출시될 예정이다. 시스템을 구축하는 파트너에는 아토스(Atos), 시스코(Cisco), 델 테크놀로지스(Dell Technologies), 후지쯔(Fujitsu), 기가바이트(GIGABYTE), 휴렛팩커드 엔터프라이즈(Hewlett Packard Enterprise), 레노버(Lenovo), 슈퍼마이크로(Supermicro)가 포함된다.

이와 함께 세계 선도적인 연구 기관들 중 일부가 차세대 슈퍼컴퓨터에 전력을 공급하기 위해 H100을 사용할 것으로 회사측은 내다봤다. 그중에는 바르셀로나 슈퍼컴퓨팅 센터, 로스 알라모스 국립 연구소, 스위스 국립 슈퍼컴퓨팅 센터(CSCS), 텍사스 고급 컴퓨팅 센터, 츠쿠바 대학 등이 있다.

아마존 웹서비스, 구글 클라우드, 마이크로소프트 애저, 오라클 클라우드 인프라(Oracle Cloud Infrastructure)가 내년부터 H100 기반 인스턴스를 클라우드에 가장 먼저 구축한다.

H100의 고급 트랜스포머 엔진 기술을 통해 기업은 대규모 언어 모델을 높은 정확도로 신속하게 개발할 수 있다. 이러한 모델의 규모가 계속 증가함에 따라 복잡성도 증가하며 때로는 교육하는 데 몇 달이 소요되기도 한다.

이를 해결하기 위해 엔비디아 네모 메가트론(NVIDIA NeMo Megatron), 마이크로소프트 딥스피드(Microsoft DeepSpeed), 구글 JAX(Google JAX), 파이토치(PyTorch), 텐서플로우(TensorFlow). XLA 등 세계 최고의 대규모 언어 모델과 딥 러닝 프레임워크 중 일부가 H100에 최적화되고 있다. 호퍼 아키텍처와 결합된 이러한 프레임워크는 AI 성능을 크게 향상시켜 며칠에서 몇 시간 내에 대규모 언어 모델을 교육할 수 있도록 지원한다.