인공지능(AI) 전용 칩(ASIC), 바이두·페이스북·아마존도 가세

전력소모량·성능 유리… 스타트업 등장으로 가격 부담 줄어

인공지능(AI) 반도체 시장에서 전용 칩(ASIC)의 영향력이 커지고 있다. 구글에 이어 바이두까지 ASIC을 택한 가운데 페이스북과 아마존도 가세했다.

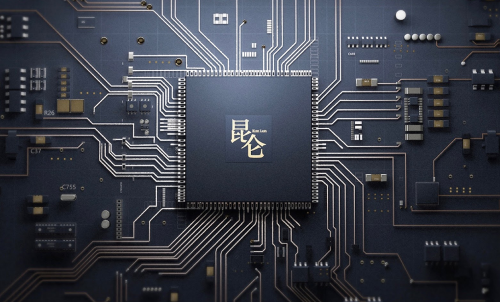

삼성전자의 14나노 공정에서 생산된 쿤룬의 연산 성능은 초당 260 TOPS(tera operations-per-second)다. 고대역폭메모리(HBM)2를 내장, 초당 512GB의 데이터를 주고받는다./바이두

업계 및 외신에 따르면 페이스북과 아마존은 최근 자사 서비스 및 제품에 최적화된 AI 연산 칩 개발을 시작했다. 범용 프로세서나 프로그래밍 가능한 반도체(FPGA)가 아닌 자체 칩을 만든다는 목표다.

페이스북은 올 초부터 기계학습(ML) 및 AI 솔루션 구현을 위한 ASIC 설계 전문가를 대거 채용하고 있다. 아마존은 반도체 업계 출신 인력들이 모여 AI 스피커 ‘알렉사(Alexa)’에 넣을 기기 내장형(on-device) AI 칩을 개발 중이다.

바이두도 최근 AI 개발자 컨퍼런스 행사에서 AI 연산용 ASIC ‘쿤룬(Kunlun)’을 공개했다.

ASIC은 특정 용도에 따라 설계, 제작되는 반도체다. 비싸고 개발 기간이 오래 걸리며, 한번 제품을 만들고 나면 기능을 바꿀 수 없지만 범용 프로세서나 FPGA보다 성능 개선에 유리하다.

케빈 크레웰(Kevin Krewell) 티리아스리서치(Tirias Research) 분석가는 “ASIC은 개발이 끝난 알고리즘을 전력 소모량을 줄여야하는 기기에 도입할 때 효율적”이라며 “알고리즘이 시시각각 변하거나 연구개발 중일 때는 중앙처리장치(CPU)나 그래픽프로세서(GPU), FPGA를 사용하는 게 낫다”고 말했다.

특히 ASIC으로 AI 칩을 만들면 고성능 프로세서의 가장 큰 문제로 지적되는 전력 소모량을 줄일 수 있다.

바이두가 개발한 AI 칩 쿤룬은 현재 바이두가 쓰고 있는 FPGA 기반 가속기보다 성능이 30배 좋지만 전력 소모량은 100W에 되지 않는다. 쿤룬은 추론용 버전과 훈련용 버전 두 가지로 개발됐는데 업계에서는 각각 데이터센터와 자율주행차에 활용할 것으로 내다봤다.

밥 오도넬(Bob O'Donnell) 테크날리시스리서치(Technalysis Research LLC) 수석 분석가는 “데이터센터에서 먼저 활용한 뒤 개발자들이 이용할 수 있게 서비스 형태로 개방할 것”이라며 “특히 자율주행차 플랫폼 ‘아폴로(Apollo)’에 최적화돼 제공될 것”이라고 말했다.

이실리콘(eSilicon), 세레브라스시스템스(Cerebras Systems), 웨이브컴퓨팅(Wave Computing), 비트메인(Bitmain) 등 전문 스타트업이 등장하고 반도체 외주생산(Foundry) 업계도 ASIC 서비스를 강화하면서 가격 부담도 줄어들고 있다. 국내에서는 팹리스 업체 넥셀(대표 강태원)이 AI ASIC 서비스를 하고 있다.