심층 학습 기반 ‘c.WAVE100’ 및 가속 엔진

올해부터 개발 중인 첨단운전자지원시스템(ADAS)에는 800만 화소 이상 초고화질(UHD) 카메라가 적용된다. 기존 HD급 카메라로는 시속 40㎞ 이상 주행 시 전방 사물을 포착할 수 없기 때문이다.

문제는 그만큼 원 정보(raw data) 처리량이 늘어나 애플리케이션프로세서(AP)나 엔진제어장치(ECU)에 부담을 준다는 것이다. 이를 해결하려면 어떻게 해야할까.

한형석 칩스앤미디어 이사는 “여러 대의 UHD 카메라에서 나온 데이터를 소프트웨어로 처리하면 수초가 걸린다”며 “이미지 데이터를 전담 처리하는 하드웨어(HW) 솔루션이 근본 해결책이 될 수 있다”고 말했다.

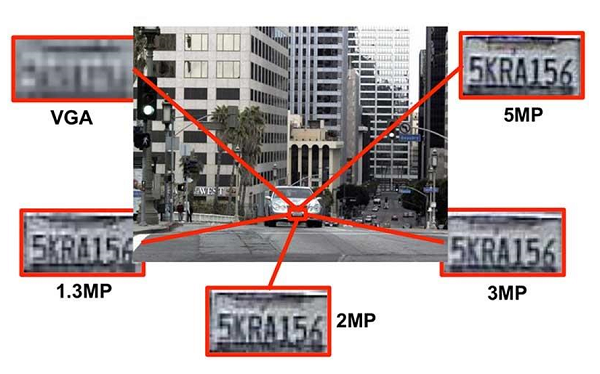

카메라가 객체(Object)를 인식하려면 객체가 최소 60여개의 픽셀(화소) 정도 크기여야 한다.

현재 130만 화소 HD급 카메라로 전방의 사물이 이 크기가 되려면 자동차와의 거리가 37m 이내로 좁혀져야 한다. 제동거리 40m 이하, 즉 시속 40㎞ 아래로 달릴 때만 긴급제동이 가능한 셈이다.

▲카메라 화소 수가 높을수록 전방 사물을 더욱 선명하게 포착할 수 있다./칩스앤미디어

시속 100㎞ 이상(제동거리 100m)으로 달리다 전방 사물을 인식, 차량을 멈추려면 같은 면적에서 픽셀 수가 HD보다 6배 이상 많은 UHD 카메라가 필요한데, 그만큼 처리해야하는 데이터의 양도 증가한다. 게다가 ADAS에는 8대의 카메라가 들어간다.

소프트웨어(SW)만으로는 전력 소모량이나 성능을 개선하기에 한계가 있다.

반도체 설계자산(IP) 업체 칩스앤미디어는 이에 착안, 심층학습(DL) 기반 컴퓨터 비전(Computer Vision) IP ‘c.WAVE100’ 및 맞춤형 나선구조신경망(CNN) 가속 엔진 IP를 개발하고 있다.

칩스앤미디어는 비디오 IP, 이미지 처리 기술에 강점을 가지고 있는 업체로, ADAS 칩(SoC) 업체 모빌아이, NXP반도체, 텔레칩스 등 차량용 반도체 업계와 협력 중이다.

‘c.WAVE100’는 객체 인식에 특화된 컴퓨터 비전 전용(Fixed-function) IP로, 자전거·자동차·사람을 구분할 수 있을 정도로 개발됐다. 시높시스나 이매지네이션 등 타사가 개발 중인 프로그래머블 IP와 달리, 이미 성능이 최적화돼있어 설계 능력이 부족한 업체도 쉽게 활용 가능하다.

현재 컴퓨터 비전 전용 IP를 개발 중인 곳은 Arm과 칩스앤미디어 뿐이다.

한 이사는 “ADAS에 UHD 카메라가 더 많이 적용될수록 하드웨어 솔루션에 대한 수요는 커질 것”이라며 “이에 대응, 완성차 업체나 자동차 부품업체, 반도체 업체 등 고객사나 협력사의 데이터를 기반으로 심층학습 IP의 성능을 강화할 계획”이라고 말했다.