시스템LSI 개발 돕느라 100여명 달라붙었지만 실패... 관련 인력 전원 재배치

한 개의 카메라만으로 깊이 추정하는 구글 'ARcore Depth' 기술까지 등장

내년 상반기까지 출시되는 삼성전자의 스마트폰에서 비행시간차(ToF) 센서를 찾아볼 수 없을 전망이다. 삼성전자가 하반기 ‘갤럭시노트20(가칭)’은 물론, ‘갤럭시S21(가칭)’를 포함한 내년 상반기 스마트폰 모델에도 ToF 센서를 넣지 않기로 결정했다.

단순히 증강현실(AR) 애플리케이션(앱)의 활용도가 떨어져서가 아니다.

시스템LSI 사업부를 통한 공급망 조성에 문제가 생겼고, 구글이 ToF 센서 없이도 깊이 정보를 인식할 수 있는 소프트웨어 개발 키트(SDK)까지 내놓았다. 아직 정확도는 떨어지지만 지금까지 제공해오던 AR 기능들을 지원하기엔 무리 없는 수준이다.

ToF 센서, 이대로 안녕?

삼성전자 무선사업부는 최근 ToF 센서 관련 협력사들에게 ‘갤럭시S21’을 포함, 내년 상반기 출시되는 자사 스마트폰 모델에 ToF 센서를 넣지 않을 계획이라고 통보했다.

삼성전자가 ToF 센서를 빼겠다고 결정한 표면적 이유는 앞서 보도했던대로 AR 앱의 활용도가 예상보다 너무 낮았기 때문이다.(KIPOST 4월 23일자 <넣을까, 뺄까... ToF를 보는 삼성의 고민> 참고)

삼성전자는 지난해 ‘갤럭시S10 5G’ 모델에 처음으로 ToF 센서를 도입하면서 간편 측정, AR 이모지 카메라, AR 이모지 스튜디오, 3D 스캐너 등의 앱을 기본으로 제공했다. 이를 통해 소비자들의 반응을 살펴보고 ToF 센서를 5G 스마트폰 전체로 확대할 계획이었지만 각 앱의 활용도가 매우 낮았다.

결국 삼성전자는 하반기 출시할 ‘갤럭시노트20’에 ToF 센서를 도입하지 않기로 확정했었다. 그게 바로 한달 전이다.

업계 관계자는 “AR 앱들이 계산기, 스마트씽스(SmartThings), 삼성뮤직 등보다도 활용도가 떨어졌고, 거의 1년에 한번 켤까말까한 수준이었다”며 “뎁스 센서 중에서는 그나마 모듈 가격이 저렴하지만, 아예 활용도가 낮기 때문에 차기작부터는 빼자는 의견이 지배적이었다”고 말했다.

믿던 시스템LSI에 발등 찍힌 무선사업부

지난해 삼성전자의 ‘갤럭시S10 5G’ 모델에 ToF 센서를 공급한 건 일본 소니(Sony)다. 소니는 지난 2015년 소프트키네틱시스템을 인수, ToF 센서 기술을 확보한 바 있다.

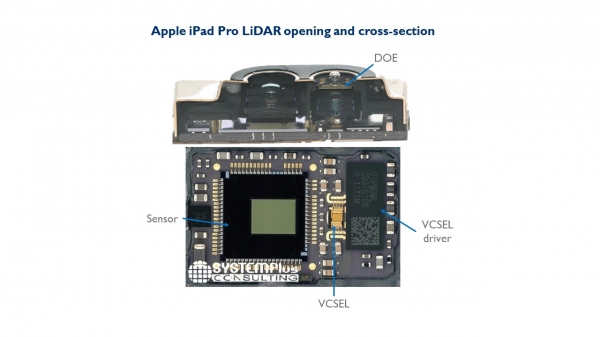

삼성전자의 ToF는 빛을 파장 형태로 쏘고 돌아오는 빛의 위상 변이(phase shift)를 분석, 거리를 측정하는 간접 ToF(iToF) 방식이다. iToF 모듈은 근거리적외선(NIR)을 쏴 보내는 수직 캐비티 광방출 레이저(VCSEL)와 VCSEL 드라이버, 돌아오는 빛 신호를 포착하는 디텍터(Detector), 센서부로 구성된다.

이 중 가장 중요한 게 소니가 공급한 센서부다. 이 센서부에는 보통 상보성금속산화물반도체(CMOS) 이미지센서가 포함되는데, 디텍터를 통해 들어온 깊이 정보를 이미지와 결합하기 때문이다.

갤럭시S10 5G 모델에는 소니의 제품이 쓰였지만, 대부분의 스마트폰 제조사들이 소니의 ToF 센서를 쓰고 있었기 때문에 삼성전자는 공급망 다변화에 대한 욕구가 컸다.

이 때 손을 들고 나온 게 시스템LSI 사업부다. 지난해 박용인 부사장이 이끌고 있는 센서사업팀에서 iToF보다 정확도가 높은 직접 ToF(dToF) 센서 개발에 착수했고 무선사업부는 이를 지원하기 위한 별도의 팀까지 꾸렸다.

무선사업부에서 모듈의 세부 사양을 전부 공유하고 소프트웨어는 공동개발하다시피 했지만, 프로젝트를 주도해야 할 센서사업팀은 별 성과를 내놓지 못했다. ToF를 다뤄본 사람도 많지 않았고, 특히 이미지 데이터와 깊이 데이터를 실시간으로 결합하는 게 쉽지 않았다고 알려졌다. 결국 무선사업부는 최근 해당 팀 인력을 다른 부서로 전환배치했다.

업계 관계자는 “무선사업부에서 센서사업팀의 ToF 개발을 도왔던 팀 인력만 100여명에 달했다”며 “성과를 내지 못하자 내부에서는 그 많은 인력을 대체 뭐하러 그쪽에 붙여놓는지 모르겠다는 비판이 나올 정도로 분위기가 좋지 않았다”고 말했다.

그렇다고 다시 소니의 손을 잡기도 애매한 상황이다.

소니는 지난해 dToF 센서 모듈로 애플과 협력관계를 맺었다. 독점 공급하는 대신 올해 하반기 아이폰 시리즈가 출시되기 전까지는 다른 업체에 dToF 모듈을 판매하지 않는 조건이다. 올해 초 애플이 출시한 ‘아이패드 프로’에도 소니의 dToF 센서가 들어갔다.

삼성 입장에서는 애플이 먼저 dToF를 도입한 다음에서야 내년 출시할 ‘갤럭시S’ 시리즈에 이를 넣을 수 있는 셈이다.

깊이 정보를 ToF 센서 없이도 구할 수 있다면?

애초에 깊이 정보를 ToF 센서 없이도 구할 수 있다면 무선사업부가 굳이 ToF 센서를 쓸 이유가 없다.

구글은 지난달 25일 한 개의 적녹청(RGB) 카메라만으로도 깊이 정보를 인식할 수 있는 AR코어(ARCore)의 뎁스(depth) 애플리케이션프로그래밍인터페이스(API)를 공개했다.

AR코어는 이전 탱고(Tango)를 대체하는 구글의 AR 개발 플랫폼으로 지난 2017년 첫 선을 보였다. ToF센서가 있으면 이 데이터까지 같이 활용하지만, 2개의 카메라나 ToF 같은 특수 센서가 아닌 단일 RGB 카메라로도 깊이 정보를 알아낼 수 있다.

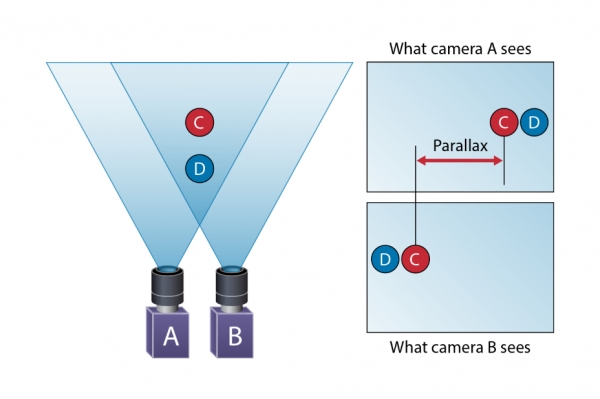

20년 전까지만 해도 하나의 카메라에서 깊이 정보를 받아들이는 건 불가능했었다. 여러 논문이 발표됐지만, 정확도가 매우 낮았다. 이에 업계는 사람의 눈처럼 두 개의 카메라를 활용하는 스테레오(Stereo) 기법이나 ToF 센서처럼 특수 센서를 활용해 사물과의 거리를 계산했다.

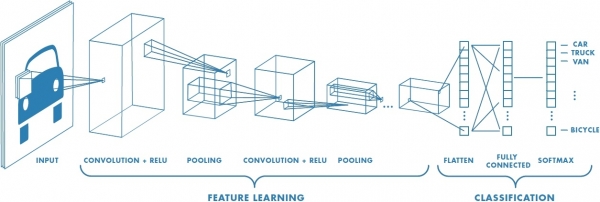

단일 카메라로 뎁스 정보를 얻어내는 것에 대한 관심이 높아진 건 불과 4~5년 전부터다. 심층 신경망(DNN) 기술이 급격히 발달하면서 DNN 알고리즘에 수천, 수만 장의 이미지를 반복학습시켜 한 개의 카메라로도 깊이 정보를 추측해낼 수 있다는 내용의 논문이 쏟아졌다.

초기 연구는 머신러닝(ML) 기술 중 하나인 합성곱 신경망(CNN)을 활용했다. CNN은 입력 계층과 출력 계층 사이 수십, 수백 개의 은닉 계층(Hidden Layers)이 존재하는데, 각 계층이 거름망 역할을 해 이미지 데이터가 가진 특징들을 검출하고 또다시 이 특징들이 계층 역할을 하는 식으로 학습한다.

최근에는 픽셀 단위의 깊이 정보를 보다 더 정확하게 추출하기 위해 서로 다른 계층에 해당하는 형상 맵(Feature map)을 통합하는 등 여러 단위(scale)의 정보를 결합하는 연구가 나오고 있다. 여기에 이미지에 조건부 무작위 영역을 지정, 정확도를 높이는 식이다.

구글의 ARcore의 뎁스 API도 비슷하다. 구글은 CNN 알고리즘에 움직임 추적(motion tracking) 기술을 가미, 정확도를 높였다.

먼저 CNN 알고리즘이 캡처된 이미지에서 특징점(feature points)을 찾으면, 그 다음 기기의 움직임에 따라 해당 특징점의 위치 변화(Parallax)를 파악한다. 이후 기기에 내장된 관성측정장치(IMU)에서 나온 데이터와 이를 결합해 기기(카메라)의 위치와 방향에 대한 값을 얻는다.

스테레오 기법이 동시에 두 카메라를 활용해 물체와의 거리를 추정하는 것처럼 기기를 움직여 두 좌표에서 특징점의 위치 변화 값을 얻어내는 셈이다.

기기를 최소 수 ㎝ 가량 움직여야하고 장소가 계속 바뀔 경우(실내에서 실외로, 실외에서 실내로) 값을 별도로 추출해야하는 번거로움이 있고, 흰 벽처럼 질감이 없는 평평한 표면은 제대로 감지를 하지 못하곤 한다는 단점이 있지만 거리 측정 같은 간단한 기능을 하기엔 무리가 없다.

이미 삼성전자는 갤럭시 시리즈에 AR코어 기술을 지원하고 있다. 최근에는 갤럭시노트10+, 갤럭시S20 울트라의 ‘간편 측정(Quick Measure)’ 앱에서 이를 활용할 수 있도록 업데이트할 준비를 하고 있다.

하지만 아직 ARcore 기반 깊이 정보는 ToF 센서 등 특수 하드웨어보다 정확도가 떨어지고, 십수m 이상 원거리에 있는 물체는 인식을 하지 못한다. 대부분의 알고리즘에서는 원거리에 있는 물체를 ‘물체’가 아닌 소실점(vanishing point)으로 처리하기 때문이다.

실제 사물 너머에 장애물을 만들거나 그 위에 가상 캐릭터를 서있게 하는 등의 간단한 AR 기술은 구현할 수 있겠지만, 1인칭 슈팅 게임(FPS) 등 복잡하고 지연시간이 중요한 앱에는 활용도가 극히 낮다.

비전 소프트웨어(SW) 업체 관계자는 “차량용으로도 같은 기술 개발이 한창이지만 아직 라이다·레이더 등 다른 센서의 정확도나 인식거리는 따라잡지 못하고 있다”며 “간단한 AR 기능은 가능하겠지만 복잡한 게임 등을 구현하는 건 불가능할 것”이라고 말했다.