엔비디아, 모델링 기법 학습시켜 대화형으로 렌더링

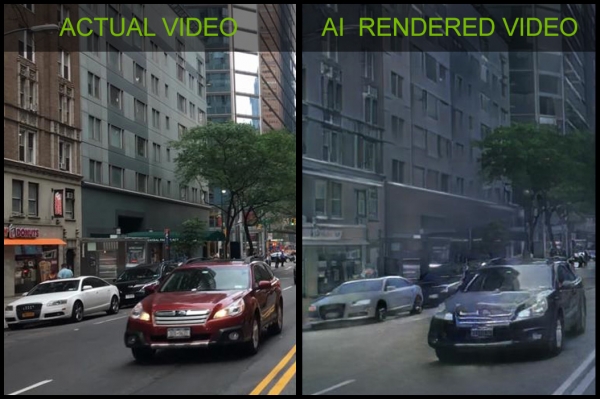

엔비디아는 자사의 연구 조직 '엔비디아 리서치'를 통해 개발된 실세계 영상으로 학습된 모델을 활용, 3D 합성 환경을 완전한 대화형으로 렌더링할 수 있는 획기적인 인공지능(AI) 연구를 최초로 선보였다고 4일 밝혔다.

보통 3D 합성 환경을 실시간으로 렌더링 하려면 가상 세계의 모든 객체를 개별적으로 모델링해야한다. 그만큼 비용과 시간 소모가 많다.

엔비디아는 이와 달리 건물이나 나무, 차량과 같은 사물을 렌더링 하기 위해 실세계 영상에서 자동으로 학습된 모델을 사용했다.

조명과 재질, 역동성을 비롯한 실제 세계의 모습을 모델링하는 방법을 학습해 객체를 쉽게 제거하고 수정하거나 추가할 수 있다.

모든 콘텐츠는 기존의 그래픽 엔진에서 생성된 3D 세계의 스케치를 영상으로 변환하는 신경망을 사용, 대화형으로 렌더링 된다.

이 기술은 게임, 자동차, 건축, 로봇 또는 가상현실을 위한 가상 세계를 신속하게 구축할 수 있는 잠재력을 제공한다. 예를 들어, 실제 위치에 기반해 대화형 장면을 생성해내거나, 사용자가 유명한 팝 스타처럼 춤을 추는 모습을 보여줄 수 있다.

연구 결과로 엔비디아는 참가자들이 도시 장면을 탐색할 수 있도록 하는 간단한 운전 게임을 소개했다.

브라이언 카탄자로(Bryan Catanzaro) 엔비디아 응용 딥 러닝 연구소 부사장은 “엔비디아는 25년간 대화형 그래픽을 생성하는 새로운 방법을 고안해 왔으나, 신경망을 활용한 건 이번이 처음"이라며 "신경망, 즉 생성적 모델은 그래픽이 생성되는 방식을 변화시킬 것”이라고 설명했다.