현대모비스·네이버랩스·SK하이닉스 등 사례 발표

세계 IT 업계가 인공지능(AI) 기술 확보에 열을 올리고 있다.

AI 알고리즘은 빅데이터에서 일정 패턴을 추출하는 학습 과정을 거쳐 만들어진다. 여기에 각 데이터는 저마다 다른 형태를 하고 있어 이를 컴퓨터가 분석할 수 있도록 바꿔줘야한다. 이에 업계는 병렬 컴퓨팅 방식으로 빠르게 데이터를 처리할 수 있는 그래픽처리장치(GPU) 기반 서버로 AI 알고리즘을 학습시키고 있다.

삼성, 현대, 네이버, SK하이닉스 등 국내 기업들도 마찬가지다. 지난 6~7일 개최된 ‘엔비디아 AI 컨퍼런스 2018’에서 국내외 기업들은 엔비디아의 GPU로 어떤 AI 알고리즘을 개발, 적용하고 있는지 발표했다.

AI로 자율주행 핵심기술 개발하는 현대모비스

현대모비스는 엔비디아의 ‘DGX-1’ 5대로 영상인식 알고리즘 등 자율주행에 필요한 핵심 기술을 개발하고 있다. ‘DGX-1’ 1대에는 8개의 GPU가 내장돼있고 여기에 워크스테이션까지 합쳐 총 5.2페타플롭스(Pflops)급 컴퓨팅 성능을 확보한 상황이다.

먼저 영상인식 알고리즘은 사람보다 뛰어난 성능을 가지도록 만드는 게 목표다.

사람은 어떤 장면을 보자마자 화면 안에 있는 여러 사물을 알아보고 경계선을 구분한다. 하지만 동일한 이미지를 기계가 인간처럼 알아보려면 사람이 일일이 이미지 속 각 사물에 대한 경계선을 구분 짓고 해당 사물의 명칭을 이미지와 함께 기록해줘야한다. 이 과정을 어노테이션(Annotation)이라고 한다.

이미지 어노테이션은 영상 인식 기술 개발 기간을 줄일 수 없게 만드는 가장 큰 장애 요인이다. 사람의 힘으로 1000만개의 이미지를 처리하려면 2500여명이 꼬박 1년을 매달려야한다.

현대모비스는 심층학습(DL)을 도입, 이 작업을 자동화하고 합성장면생성(SSG)으로 학습 데이터베이스(DB)를 생성하고 관리할 수 있게 했다. 이를 통해 개발 단계에서의 엔지니어링 효율을 확보했고 적기(TAT) 제어 및 실시간 동작, 빠른 응답 속도를 구현했다고 설명했다.

회사는 내년 엔비디아의 최신 GPU 서버 ‘DGX-2’를 5대 추가 구입해 10Pflops 이상의 컴퓨팅 자원을 확보할 계획이다. ‘DGX-2’는 1대에 5억원 정도다. 고속 통신(10Gbps) 기술로 ‘DGX-1’ 그룹 간 클러스터를 구축해 ‘GPU 컴퓨팅 팜(Computing farm)’을 구축할 예정이다.

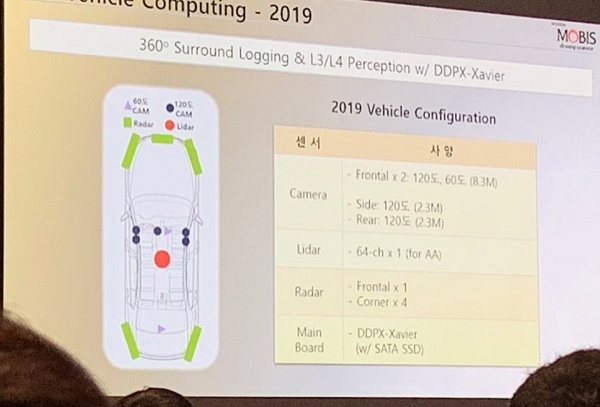

올해 엔비디아의 ‘드라이브 PX2’ 시스템을 기반으로 한 ‘데이터 수집 시스템’을 통해 자율주행에 필요한 데이터도 수집했다. 이 시스템에는 라이다(LiDAR)와 2.3MP급 카메라(차량 앞뒤 2개), 2TB 솔리드스테이트드라이브(SSD) 등이 포함됐다.

내년에는 360도 서라운드 뷰 시스템이 장착된 데이터 수집 시스템을 내장한 자율주행차를 내놓을 계획이다. 이 시스템은 엔비디아의 ‘자비에(Xavier)’ 기반으로 2.3MP급 및 9.3MP급 카메라 7개와 라이다, 레이더(Radar), SATA SSD 등으로 구성된다. 개발 목표 시점은 내년 10월이다.

앞으로의 과제는 상용차에 적용할 수 있을 정도의 자율주행 시스템을 개발하는 것이다.

이진언 현대모비스 이사는 “자율주행을 구현하려면 데스크탑 10대 정도의 컴퓨팅 파워가 필요하다”며 “이를 구현할 수 있을 정도로 성능이 좋고 신뢰성도 높은 반도체가 필요하다”고 말했다.

네이버랩스, 값비싼 센서 없는 자율주행 로봇 내놓는다

네이버에서 AI 기술 개발을 이끌고 있는 네이버랩스는 이미 엔비디아의 GPU를 기반으로 지도 로봇 ‘M1’과 자율주행 로봇 ‘어라운드(AROUND)’, 자율주행 카트 로봇 ‘AIRCART’ 등을 상용화했다.

가장 먼저 GPU 기술이 적용된 건 ‘M1’이다. 현재 네이버 맵(Map) 서비스는 전부 사람이 일일이 정보를 입력해 만들어졌다. 하지만 2년마다 전체 상점의 25%는 폐업하기 때문에 매번 업데이트를 해줘야 한다.

‘M1’은 실내를 주행하면서 주변의 사진을 찍어 지도를 그리는 로봇이다. 앞서 네이버랩스는 ‘M1’으로 코엑스의 전 상점을 돌며 2시간 만에 코엑스 실내 지도를 그렸다. 상점이 바뀌는 것도 인식해 반영한다. 네이버랩스는 이를 코엑스 외 다른 건물에도 도입할 계획이다.

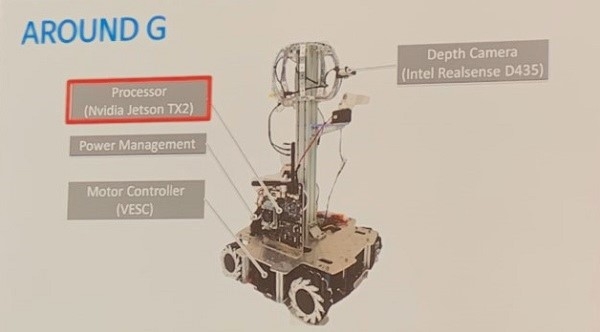

하지만 ‘M1’을 포함한 자율주행 로봇은 값비싼 라이다와 3D 뎁스 센서 등이 필요하다. 네이버랩스는 이 점에 착안해 센서 없이도 자율주행할 수 있는 로봇인 ‘어라운드 G’를 개발하고 있다. 센서가 없어지면 로봇 가격도 그만큼 떨어진다.

석상옥 네이버랩스 로보틱스&오토노머스 드라이빙 그룹장은 “‘어라운드 G’의 가격이 얼마가 될 지는 밝힐 수 없지만, 기존 로봇과 비교하면 ‘드라마틱’한 수준으로 가격이 떨어질 것”이라며 “차선을 구분한 지도와 첨단운전자지원시스템(ADAS) 등 자율주행 솔루션도 개발 중”이라고 말했다.

SK하이닉스, 검사(Inspection)에 AI 도입한다

SK하이닉스는 검사(Inspection) 공정에 AI를 도입할 계획이다.

현재 패키지 계측·검사(MI) 공정 중 인스펙션 단계는 자동비전검사(AVI) 장비를 거쳐 불량품으로 판정된 칩(Chip)들을 사람이 일일이 육안으로 검사하는 2개의 과정을 거친다. AVI 장비가 불량으로 구분하는 칩 중 98.5%가 양품이기 때문이다. 이 육안 검사 과정에 전체 MI 운영 시간의 65%, 인력의 60%가 소모된다.

SK하이닉스는 이에 검사 공정을 완전히 자동화할 수 있는 알고리즘을 개발하고 있다. 불량인데도 양품으로 판정되는 미검율은 0%를 달성하고 양품을 불량품으로 판정하는 과검율을 합쳐 10% 이내로 정확도를 높이는 게 목표다.

관건은 반도체의 오류점(Defect)을 모델링하는 것이다. 디펙트는 워낙 다양한 형태와 크기를 가지고 있고 공정 레시피가 바뀌면 전에 없던 새로운 모습의 디펙트가 생긴다.

이석형 SK하이닉스 책임은 “학교나 연구소에서는 비교적 깨끗한 데이터만 가지고 알고리즘을 개발하지만, 현장에서는 학습(Training)을 위한 라벨링 자체에 에러가 생겨 쉽지 않았다”고 설명했다.

CCTV를 통해 장비의 이상 동작을 미리 탐지할 수 있는 솔루션도 개발했다.

엔지니어가 모든 운행 장비를 모니터링하기 어렵고, 각 장비에 내장된 예지 보전 알고리즘은 장비 내부 상황은 알 수 있어도 외부 상황에 대한 감지 능력은 떨어졌기 때문이다. 이에 회사는 이미지 프로세싱을 통해 장비 이상 동작을 탐지, 알려주는 알고리즘을 개발했다.

SK하이닉스는 향후 엣지 컴퓨팅을 도입, 현업에서 측정 또는 수집되는 데이터를 실시간으로 처리해 업무 효율성을 높일 계획이다. 현재는 상황에 맞는 사양을 정의하기 위해 모의 실험을 진행 중이다.

이 책임은 “제조사가 가지고 있는 생산 정보 데이터에 각 장비 내부에 실시간을 쌓이는 데이터까지 합치면 거대한 빅데이터가 된다”며 “각 장비에 저장돼있는 데이터들을 수집해 가치를 발굴할 수 있도록 협력사들과 협업 중”이라고 말했다.